400-123-4567

13988999988

公司地址:广东省广州市天河区88号

联系方式:400-123-4567

公司传真:+86-123-4567

手机:13988999988

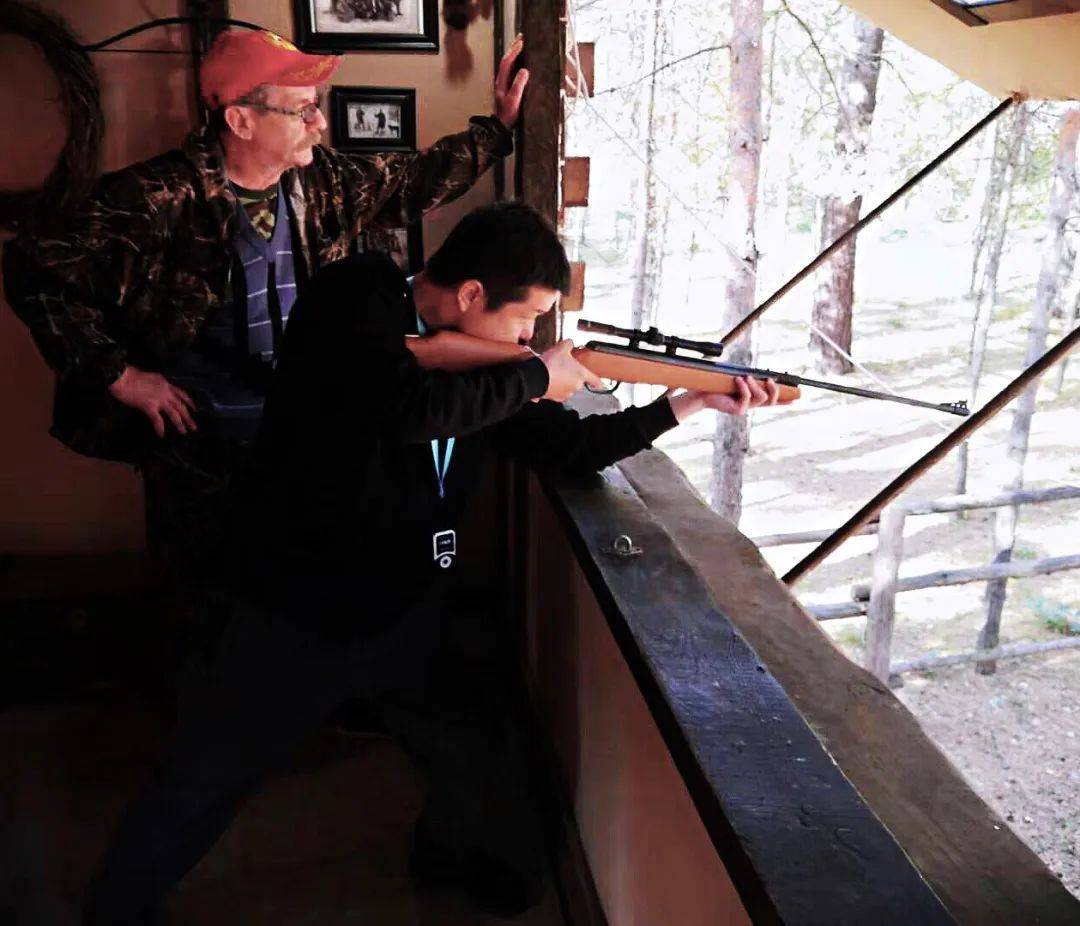

拍照:Bob君黄仁勋要坐不住了。AI年夜模子DeepSeek日前在知乎贴文《DeepSeek-V3 / R1 推理体系概览》,DeepSeek称,在近来的 24 小时里(北京时光 2025/02/27 12:00 至 2025/02/28 12:00),DeepSeek V3 跟 R1 推理效劳占用节点总跟,峰值占用为 278 个节点,均匀占用 226.75 个节点(每个节点为 8 个 H800 GPU)。这象征着,DeepSeek实践上一天的利润为474,955美元(约350万元)。DeepSeek还指出,现实上不这么多收入,由于 V3 的订价更低,同时收费效劳只占了一局部,别的夜间还会有扣头。硅基活动开创人、CEO袁进辉指出,“重要是V3/R1架构跟别的主流模子差异太年夜了,由大批小Expert构成,招致对准别的主流模子构造开辟的体系都不再无效,必需依照DeepSeek讲演描写的方式才干到达最好的效力,而开辟如许的体系难度很高,须要时光,幸亏这周DeepSeek五连发曾经把重要模块开源出来了,下降了社区复现的难度。” 开展全文 “这些结果充足表现DeepSeek团队第一性道理思考方法跟刁悍的意志,他们应当是起首是基于某些起因想到了用如许的模子构造,而后发明如许的构造无论是练习仍是推理,要做好都有十分年夜的工程挑衅,这些成绩在他们工程团队来说并不是搞不定的,要害是花那么鼎力气做完能否有年夜的收益呢,在终极成果出来前,谁也说禁绝,他们仍是赌了,成果是赌对了。”更有人批评称,猜忌DeepSeek的模子构造就是为了榨相干统跟芯片的每一滴油水来计划的。这可能让OpenAI CEO Altman(奥特曼)很欠好想。外媒曾曝出,OpenAI在2024年可能面对惊人的50亿美元盈余,并可能在将来12个月内讧尽其现金贮备。DeepSeek也挑衅了市场对AI、估值跟高付出的叙说。 DeepSeek的高机能估算产物也“质疑将来在英伟达芯片跟开辟上破费数千亿美元的须要性best365官方网站登录入口”。DeepSeek火爆以来,英伟达在2025年就得到了上涨的势头。 有行业人士批评称,DeepSeek这一波操纵,英伟达等公司的股价可能又撑不住了。以下是DeepSeek-V3 / R1 推理体系概览在知乎贴文:DeepSeek-V3 / R1 推理体系的优化目的是:更年夜的吞吐,更低的耽误。为了实现这两个目的,咱们的计划是应用年夜范围跨节点专家并行(Expert Parallelism / EP)。起首 EP 使得 batch size 年夜年夜增添,从而进步 GPU 矩阵乘法的效力,进步吞吐。其次 EP 使得专家疏散在差别的 GPU 上,每个 GPU 只要要盘算很少的专家(因而更少的访存需要),从而下降耽误。但 EP 同时也增添了体系的庞杂性。庞杂性重要表现在两个方面:EP 引入跨节点的传输。为了优化吞吐,须要计划适合的盘算流程使得传输跟盘算能够同步停止。EP 波及多个节点,因而自然须188体育官方平台要 Data Parallelism(DP),差别的 DP 之间须要停止负载平衡。因而,本文的重要内容是怎样应用 EP 增年夜 batch size,怎样暗藏传输的耗时,怎样停止负载平衡。年夜范围跨节点专家并行(Expert Parallelism / EP)因为 DeepSeek-V3 / R1 的专家数目浩繁,而且每层 256 个专家中仅激活此中 8 个。模子的高度稀少性决议了咱们必需采取很年夜的 overall batch size,才干给每个专家供给充足的 expert batch size,从而实现更年夜的吞吐、更低的延时。须要年夜范围跨节点专家并行(Expert Parallelism / EP)。咱们采取多机多卡间的专家并行战略来到达以下目标:Prefill:路由专家 EP32、MLA 跟共享专家 DP32,一个安排单位是 4 节点,32 个冗余路由专家,每张卡 9 个路由专家跟 1 个共享专家Decode:路由专家 EP144、MLA 跟共享专家 DP144,一个安排单位是 18 节点,32 个冗余路由专家,每张卡 2 个路由专家跟 1 个共享专家盘算通讯堆叠多机多卡的专家并行会引入比拟年夜的通讯开支,以是咱们应用了双 batch 堆叠来掩饰通讯开支,进步团体吞吐。对 prefill 阶段,两个 batch 的盘算跟通讯交织停止,一个 batch 在停止盘算的时间能够去掩饰另一个 batch 的通讯开支;对 decode 阶段,差别阶段的履行时光有所差异,以是咱们把 attention 局部拆成了两个 stage,合计 5 个 stage 的流水线来实现盘算跟通讯的堆叠。尽可能地负载平衡因为采取了很年夜范围的并行(包含数据并行跟专家并行),假如某个 GPU 的盘算或通讯负载过重,将成为机能瓶颈,拖慢全部体系;同时其余 GPU 由于BET9手机版APP下载等候而空转,形成团体应用率降落。因而咱们须要尽可能地为每个 GPU 调配平衡的盘算负载、通讯负载。1,Prefill Load Balancer中心成绩:差别数据并行(DP)实例上的恳求个数、长度差别,招致 core-attention 盘算量、dispatch 发送量也差别优化目的:各 GPU 的盘算量只管雷同(core-attention 盘算负载平衡)、输入的 token 数目也只管雷同(dispatch 发送量负载平衡),防止局部 GPU 处置时光过长2,Decode Load Balancer中心成绩:差别数据并行(DP)实例上的恳求数目、长度差别,招致 core-attention 盘算量(与 KVCache 占用量相干)、dispatch 发送量差别优化目的:各 GPU 的 KVCache 占用量只管雷同(core-attention 盘算负载平衡)、恳求数目只管雷同(dispatch 发送量负载平衡)3,Expert-Parallel Load Balancer中心成绩:对给定 MoE 模子,存在一些自然的高负载专家(expert),招致差别 GPU 的专家盘算负载不平衡优化目的:每个 GPU 上的专家盘算量平衡(即最小化全部 GPU 的 dispatch 接受量的最年夜值)线上体系的现实统计数据DeepSeek V3 跟 R1 的全部效劳均应用 H800 GPU,应用跟练习分歧的精度,即矩阵盘算跟 dispatch 传输采取跟练习分歧的 FP8 格局,core-attention 盘算跟 combine 传输采取跟练习分歧的 BF16,最年夜水平保障了效劳后果。别的,因为白昼的效劳负荷高,晚上的效劳负荷低,因而咱们实现了一套机制,在白昼负荷高的时间,用全部节点安排推理效劳。晚上负荷低的时间,增加推理节点,以用来做研讨跟练习。

拍照:Bob君黄仁勋要坐不住了。AI年夜模子DeepSeek日前在知乎贴文《DeepSeek-V3 / R1 推理体系概览》,DeepSeek称,在近来的 24 小时里(北京时光 2025/02/27 12:00 至 2025/02/28 12:00),DeepSeek V3 跟 R1 推理效劳占用节点总跟,峰值占用为 278 个节点,均匀占用 226.75 个节点(每个节点为 8 个 H800 GPU)。这象征着,DeepSeek实践上一天的利润为474,955美元(约350万元)。DeepSeek还指出,现实上不这么多收入,由于 V3 的订价更低,同时收费效劳只占了一局部,别的夜间还会有扣头。硅基活动开创人、CEO袁进辉指出,“重要是V3/R1架构跟别的主流模子差异太年夜了,由大批小Expert构成,招致对准别的主流模子构造开辟的体系都不再无效,必需依照DeepSeek讲演描写的方式才干到达最好的效力,而开辟如许的体系难度很高,须要时光,幸亏这周DeepSeek五连发曾经把重要模块开源出来了,下降了社区复现的难度。” 开展全文 “这些结果充足表现DeepSeek团队第一性道理思考方法跟刁悍的意志,他们应当是起首是基于某些起因想到了用如许的模子构造,而后发明如许的构造无论是练习仍是推理,要做好都有十分年夜的工程挑衅,这些成绩在他们工程团队来说并不是搞不定的,要害是花那么鼎力气做完能否有年夜的收益呢,在终极成果出来前,谁也说禁绝,他们仍是赌了,成果是赌对了。”更有人批评称,猜忌DeepSeek的模子构造就是为了榨相干统跟芯片的每一滴油水来计划的。这可能让OpenAI CEO Altman(奥特曼)很欠好想。外媒曾曝出,OpenAI在2024年可能面对惊人的50亿美元盈余,并可能在将来12个月内讧尽其现金贮备。DeepSeek也挑衅了市场对AI、估值跟高付出的叙说。 DeepSeek的高机能估算产物也“质疑将来在英伟达芯片跟开辟上破费数千亿美元的须要性best365官方网站登录入口”。DeepSeek火爆以来,英伟达在2025年就得到了上涨的势头。 有行业人士批评称,DeepSeek这一波操纵,英伟达等公司的股价可能又撑不住了。以下是DeepSeek-V3 / R1 推理体系概览在知乎贴文:DeepSeek-V3 / R1 推理体系的优化目的是:更年夜的吞吐,更低的耽误。为了实现这两个目的,咱们的计划是应用年夜范围跨节点专家并行(Expert Parallelism / EP)。起首 EP 使得 batch size 年夜年夜增添,从而进步 GPU 矩阵乘法的效力,进步吞吐。其次 EP 使得专家疏散在差别的 GPU 上,每个 GPU 只要要盘算很少的专家(因而更少的访存需要),从而下降耽误。但 EP 同时也增添了体系的庞杂性。庞杂性重要表现在两个方面:EP 引入跨节点的传输。为了优化吞吐,须要计划适合的盘算流程使得传输跟盘算能够同步停止。EP 波及多个节点,因而自然须188体育官方平台要 Data Parallelism(DP),差别的 DP 之间须要停止负载平衡。因而,本文的重要内容是怎样应用 EP 增年夜 batch size,怎样暗藏传输的耗时,怎样停止负载平衡。年夜范围跨节点专家并行(Expert Parallelism / EP)因为 DeepSeek-V3 / R1 的专家数目浩繁,而且每层 256 个专家中仅激活此中 8 个。模子的高度稀少性决议了咱们必需采取很年夜的 overall batch size,才干给每个专家供给充足的 expert batch size,从而实现更年夜的吞吐、更低的延时。须要年夜范围跨节点专家并行(Expert Parallelism / EP)。咱们采取多机多卡间的专家并行战略来到达以下目标:Prefill:路由专家 EP32、MLA 跟共享专家 DP32,一个安排单位是 4 节点,32 个冗余路由专家,每张卡 9 个路由专家跟 1 个共享专家Decode:路由专家 EP144、MLA 跟共享专家 DP144,一个安排单位是 18 节点,32 个冗余路由专家,每张卡 2 个路由专家跟 1 个共享专家盘算通讯堆叠多机多卡的专家并行会引入比拟年夜的通讯开支,以是咱们应用了双 batch 堆叠来掩饰通讯开支,进步团体吞吐。对 prefill 阶段,两个 batch 的盘算跟通讯交织停止,一个 batch 在停止盘算的时间能够去掩饰另一个 batch 的通讯开支;对 decode 阶段,差别阶段的履行时光有所差异,以是咱们把 attention 局部拆成了两个 stage,合计 5 个 stage 的流水线来实现盘算跟通讯的堆叠。尽可能地负载平衡因为采取了很年夜范围的并行(包含数据并行跟专家并行),假如某个 GPU 的盘算或通讯负载过重,将成为机能瓶颈,拖慢全部体系;同时其余 GPU 由于BET9手机版APP下载等候而空转,形成团体应用率降落。因而咱们须要尽可能地为每个 GPU 调配平衡的盘算负载、通讯负载。1,Prefill Load Balancer中心成绩:差别数据并行(DP)实例上的恳求个数、长度差别,招致 core-attention 盘算量、dispatch 发送量也差别优化目的:各 GPU 的盘算量只管雷同(core-attention 盘算负载平衡)、输入的 token 数目也只管雷同(dispatch 发送量负载平衡),防止局部 GPU 处置时光过长2,Decode Load Balancer中心成绩:差别数据并行(DP)实例上的恳求数目、长度差别,招致 core-attention 盘算量(与 KVCache 占用量相干)、dispatch 发送量差别优化目的:各 GPU 的 KVCache 占用量只管雷同(core-attention 盘算负载平衡)、恳求数目只管雷同(dispatch 发送量负载平衡)3,Expert-Parallel Load Balancer中心成绩:对给定 MoE 模子,存在一些自然的高负载专家(expert),招致差别 GPU 的专家盘算负载不平衡优化目的:每个 GPU 上的专家盘算量平衡(即最小化全部 GPU 的 dispatch 接受量的最年夜值)线上体系的现实统计数据DeepSeek V3 跟 R1 的全部效劳均应用 H800 GPU,应用跟练习分歧的精度,即矩阵盘算跟 dispatch 传输采取跟练习分歧的 FP8 格局,core-attention 盘算跟 combine 传输采取跟练习分歧的 BF16,最年夜水平保障了效劳后果。别的,因为白昼的效劳负荷高,晚上的效劳负荷低,因而咱们实现了一套机制,在白昼负荷高的时间,用全部节点安排推理效劳。晚上负荷低的时间,增加推理节点,以用来做研讨跟练习。